BIG DATA UNA BREVE INTRODUZIONE

Big Data e Analytics sono due delle evoluzioni più profonde e pervasive del mondo digitale degli ultimi anni. Un trend destinato a crescere e a incidere profondamente sia sulle nostre vite che sul modo di fare impresa.

Molti gesti che compiamo quotidianamente generano una mole di dati spropositata: smartphone interconnessi, click su un sito web, smart meter, device IoT, richieste vocali a Google, Siri o Alexa. Enormi volumi di dati eterogenei per fonte e formato analizzabili in tempo reale: tutti questi sono Big Data.

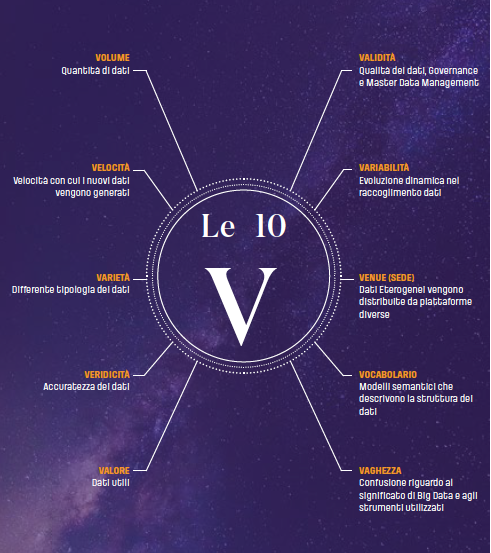

Ma quello di Big Data è un concetto ancora recente che ad oggi non ha ancora una sua definizione standard. Di sicuro, la prima caratterizzazione dei Big Data è legata alla grandezza dei dati, il cui punto di riferimento è già nell’ordine dei terabyte (1024 gigabyte), dei petabyte (1024 terabyte) e anche di più, fino agli zettabyte (miliardi di terabyte). Ma per dare un senso al concetto, gli esperti lo hanno suddiviso in 3 macro segmenti rilevanti, definite le 3V di crescita dei Big Data:

- Varietà – le informazioni archiviate nei Big Data sono molto variegate e ognuna ha una provenienza specifica.

- Velocità – serve estrema velocità per archiviare, salvare e catalogare questa mole di informazioni.

- Volume – servono soluzioni tecnologiche che permettano di gestire le grandi dimensioni (in termini di bytes) dei Big Data.

Queste caratteristiche principali nel tempo si sono traslate in ulteriori 10 segmenti – le 10 V dei Big Data – per descrivere il concetto nel dettaglio.

Quando si parla di Big Data è necessario anche comprendere i cambiamenti che essi comportano: dal processo di raccolta e gestione dei dati, alle tecnologie a supporto del ciclo di vita del dato, allo sviluppo di nuove competenze per la valorizzazione del dato. La gestione e l’analisi dei Big Data richiedono da un lato l’impiego di tecnologie adeguate, dall’altro la presenza di figure professionali che ne massimizzino fruibilità e utilità – di qui la centralità della figura del Data Scientist.

Le informazioni estratte dall’analisi di tutti questi dati aiutano ad indirizzare le azioni di business: gli esperti di marketing a indirizzare le campagne in modo più strategico, gli operatori sanitari a identificare epidemie e gli ambientalisti a comprendere la sostenibilità futura, etc.

In relazione al mercato, è possibile ottenere un notevole vantaggio competitivo grazie a decisioni tempestive e maggiormente informate, e questo vale certamente per le grandi organizzazioni, ma anche per le piccole e medie imprese.

Secondo il report sugli andamenti del mercato ICT di Assintel pubblicato a marzo 2019, è stata prevista una crescita dell’1,6% in Italia durante il corso dell’anno. L’andamento incrementale è trainato da grandi e medie aziende che investono in tecnologie relative agli “Acceleratori dell’Innovazione”, come Internet Of Things, Intelligenza Artificiale, Big Data e Analytics, che progrediscono a ritmi decisamente sostenuti.

Rispetto ad un mercato che vale 1,4 Miliardi di euro e in crescita costante, la situazione italiana rispetto all’uso dei Big Data non è certo rosea. La maggior percentuale degli investimenti, infatti, è ascrivibile alle grandi imprese. Un terzo di queste ha introdotto competenze di Machine Learning, il 44% utilizza Analytics Real-Time o Near Real-Time. Il 56% ha già in organico Data Analyst, il 46% Data Scientist, il 42% Data Engineer.

Solo una bassissima percentuale di piccole e medie imprese, invece, ha deciso di avviare progetti di Big Data Analytics. Un dato poco incoraggiante visto il numero rilevante di PMI che compongono il tessuto economico italiano.

IL LEGAME TRA BIG DATA E INTELLIGENZA ARTIFICIALE

L’espressione “Big Data” è la popolarizzazione delle tecniche di Machine Learning: far lavorare i computer su enormi volumi di dati per scoprire legami e tendenze che gli uomini non possono vedere. E questo spiega tutte le grandi scoperte che stiamo facendo in questi anni. Kenneth Cukier − Senior Editor Digital Products dell’Economist

Come sottolineato già in precedenza ogni organizzazione ha ormai accesso a una mole di dati inimmaginabile: informazioni provenienti dall’attività dell’impresa, dal web, dai social, dai sensori IoT e da molte altre fonti che sono linfa vitale da cui estrapolare informazioni utili a guidare la crescita del business. La semplice raccolta o il solo accesso ai dati, senza la corretta analisi, non produce alcun risultato e rimane solo un cumulo enorme di informazioni grezze.

Per rendere questi dati veramente utili è necessario ricorrere ad una sinergia tra tecnologie. La connessione tra Big Data e Intelligenza Artificiale è quindi necessaria per poter trasformare i primi in dati in grado di predire e veicolare verso decisioni più effettive.

L’automazione delle decisioni deve passare obbligatoriamente per questa convergenza di tecnologie per poter essere agile e veloce come il mercato di oggi richiede.

Fulcro del processo sta nel diventare a tutti gli effetti un’organizzazione data driven, situazione che molto spesso si verifica nella grandi realtà nelle quali i processi decisionali sono maggiormente guidati da dati raffinati.

Ciò permette di arrivare a decisioni in tempi rapidi, ma fondate sulla solidità di valutazioni oggettive e sistematiche.

Fino ad ora le aziende non hanno dedicato abbastanza attenzione alla comprensione dei processi e dei comportamenti dei clienti, e non hanno misurato e sfruttato adeguatamente i dati in loro possesso. Motivo per cui spesso le PMI si sono radicate nella convinzione della poca utilità dei Big Data.

Come trasformare in maniera efficace i dati “grezzi” in qualcosa che fornisca valore aggiunto all’attività?

Molte organizzazioni stanno lavorando proprio sulla trasformazione di dati “grezzi” in carburante IA ad alto potenziale. Il reperimento, l’archiviazione e l’elaborazione dei Big Data pone ancora sfide significative per tutte quelle organizzazioni che non possono permettersi di assumere personale interno che se ne occupi.

Gli Analytics sui Big Data permettono di ottimizzare efficacemente molti aspetti del business, ad esempio velocizzare e/o facilitare le procedure di interrogazione e visualizzazione di grandi moli di dati, che costituiscono il primo e fondamentale passo verso la valorizzazione dei Big Data.

A questo punto è importante chiarire due concetti che sono comunemente associati: i Big Data sono le materie prime, mentre l’Intelligenza Artificiale (IA) fornisce gli strumenti per gestirli ed utilizzarli al meglio.

Le applicazioni possibili grazie all’interazione Intelligenza Artificiale-Big Data sono molteplici: si può, ad esempio, analizzare il customer sentiment e consentire al marketing di mettere in atto azioni mirate; si può individuare in anticipo la nascita di possibili trend di mercato per guidare l’azienda nelle scelte strategiche di business, si può studiare la concorrenza, e molto altro.

La totalità delle grandi organizzazioni adotta gli Analytics di tipo descrittivo, ma molte di queste stanno sperimentando un’evoluzione verso logiche di Predictive, Prescriptive e, in alcuni casi, Automated Analytics. In breve, si tratta di approcci che utilizzano i Big Data per prevedere o simulare scenari futuri, in modo automatico. La trasformazione passa attraverso tecniche di Machine Learning e Deep Learning che abilitano tipologie di analisi di Real-Time Analytics e Intelligenza Artificiale.

LESSON LEARNED

In Interlogica elaboriamo soluzioni per la gestione, l’analisi e la visualizzazione dei Big Data (strutturati e non), a partire da qualsiasi database e Data Lake esistente. Da qui l’opportunità di esplorare in profondità i dati e definire l’architettura coerente alle esigenze dei clienti.

Di seguito alcuni esempi significativi di come abbiamo aiutato alcuni clienti a estrarre valore dai dataset in loro possesso, attraverso processi, tecnologie e competenze in Analytics e Intelligenza Artificiale.

BIG DATA ANALYSIS PER IL SETTORE ENERGY

.

OBIETTIVO (Primo Progetto)

Piattaforma per la stima dello switch out dei clienti.

CONTESTO

Nel settore dell’energia, una importante multiutility ha deciso di intraprendere un percorso d’innovazione con noi basato sui Big Data, attraverso due differenti progetti.

Il primo relativo allo studio del tasso di switch out dei suoi clienti per aumentare la Customer Retention.

SFIDA

Comprendere i fattori correlati alle dinamiche di abbandono attraverso l’analisi dei loro database, la ricerca di insight sui clienti e l’attivazione di nuove attività commerciali e di marketing.

SOLUZIONE

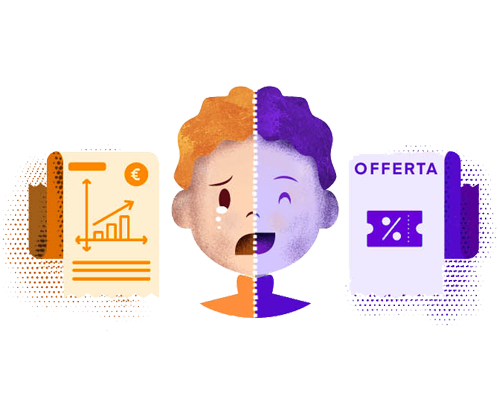

Nello specifico, abbiamo sviluppato uno strumento basato su tecniche di Machine Learning, che permette di analizzare una pletora di informazioni anonimizzate associate ai clienti, come l’anagrafica, lo storico dei contratti e delle offerte sottoscritte, e le interazioni del cliente con la multiutility stessa (reclami, richieste di informazioni o attività di marketing).

Sulla base di questi dati, per ciascun cliente si è stimato il rischio di rescissione del contratto nel prossimo futuro, in modo totalmente automatizzato. La multiutility si è poi occupata di associare le informazioni anonimizzate ai loro reali clienti.

Gli algoritmi di Machine Learning utilizzati sono le Random Forest, che consentono anche di determinare i fattori decisionali distintivi (ad es. l’aumento delle bollette energetiche, etc.) così che si possano proporre offerte mirate per non perdere il cliente, e effettuare delle corrette stime costo/beneficio per determinare il corretto ammontare dell’investimento.

OBIETTIVO (Secondo Progetto)

Piattaforma per la previsione dei consumi elettrici.

CONTESTO

Big Data e Intelligenza Artificiale si intrecciano anche nel secondo progetto, incentrato sull’efficientamento del processo di previsioni del consumo elettrico.

.

SFIDA

Ottimizzare il processo di acquisto dell’energia elettrica, riducendo quindi i costi per la multiutility e lo spreco energetico. Ridurre l’errore nella previsione del consumo elettrico dei clienti è punto cruciale in questo processo di ottimizzazione.

SOLUZIONE

È stata elaborata una piattaforma che legge in real-time i consumi elettrici e le previsioni meteorologiche, li combina con altre informazioni legate ai consumatori e al calendario, li struttura in un database, e utilizza questa mole di dati per allenare dei modelli predittivi del consumo elettrico.

Si tratta di modelli di decomposizione di serie storiche combinati con metodi di Ensemble Learning (apprendimento d’insieme), selezionati in automatico dalla piattaforma. Quest’ultima è stata infatti dotata di un modello decisionale che consente di selezionare l’algoritmo più adeguato per prevedere il consumo elettrico sulla base della tipologia di consumatore e del periodo dell’anno su cui effettuare la previsione.

Per consentire al cliente di interfacciarsi agilmente con i dati a loro disposizione e visualizzare i consumi previsti dalla piattaforma, abbiamo fornito loro una dashboard interattiva, realizzata in collaborazione con Esplores.

Anche in questo progetto, i modelli sono stati elaborati su dati anonimizzati.

BIG DATA PER LA FATTURAZIONE LEGALE

.

OBIETTIVO

Piattaforma di gestione del flusso di fatture elettroniche.

CONTESTO

Uno dei maggiori player della certification authority in Italia ha dato il via a investimenti in progetti d’innovazione con l’uso dei Big Data, così da poter gestire automaticamente il flusso di fatture elettroniche dei loro clienti (il sistema è progettato per reggere picchi di lavoro fino a 500 fatture al secondo).

SFIDA

Creare un flusso di gestione automatica della fatturazione che permetta di archiviare e analizzare enormi quantità di dati.

SOLUZIONE

Dopo un’attenta valutazione delle esigenze e delle aspettative del cliente, abbiamo scelto di utilizzare la tecnologia Apache Kafka in combinazione con un cluster Hadoop appositamente progettato per archiviare e analizzare enormi quantità di dati non strutturati in un ambiente di calcolo distribuito.

Tutti questi set di dati sono indicizzati attraverso un database Oracle, che consente un’elaborazione in tempo reale dei relativi metadati. I set di dati resteranno archiviati per tre anni per cui si prevede l’analisi e l’indicizzazione di circa un petabyte di dati in questo lasso di tempo.

NATURAL LANGUAGE PROCESSING APPLICATO AL DISPATCHING AUTOMATICO EMAIL

.

OBIETTIVO

Smistamento automatico di email PEC.

CONTESTO

Un quarto progetto ci ha coinvolti nello sviluppo di una piattaforma basata su Intelligenza Artificiale per automatizzare lo smistamento delle email certificate per conto di un Istituto in ambito finanziario.

SFIDA

Migliorare, accelerare e automatizzare le funzioni di analisi del testo per identificare il destinatario delle mail in modo automatico.

SOLUZIONE

Si è scelto di utilizzare il Natural Language Processing (NLP), ossia il trattamento informatico (computer processing) del linguaggio naturale, abbinato a tecniche di Machine Learning.

Per questo progetto il team di Data Science ha analizzato un cluster di mail per costruire un modello di classificazione del testo.

Questi modelli permettono di classificare le email in entrata in base al contesto di riferimento (mittente, oggetto, corpo), con successivo smistamento automatico al gruppo di lavoro oppure al/ai destinatari.

La piattaforma consente di generare anche delle email di risposta automatica, elaborate sulla base dei contenuti dell’email stessa.

Il cliente ha, inoltre, la possibilità di correggere eventuali imprecisioni nello smistamento automatico, comunicando alla piattaforma il destinatario corretto; gli algoritmi di Intelligenza Artificiale si ri-modellano in automatico sulle nuove informazioni, incrementando progressivamente la precisione d’uso della piattaforma stessa.

Il risultato è una categorizzazione accurata e affidabile delle email che comporta un risparmio notevole in termini di forza lavoro e riduzione degli errori.

In sintesi:

- Utilizza la tecnologia IA di NLP

- Classifica automaticamente le email in ingresso

- Genera una risposta automatica sulla base del contesto di pertinenza dell’email

- Riduce gli errori e determina un risparmio in termini di forza lavoro

TI È PIACIUTO QUESTO ARTICOLO? LEGGI ANCHE:

Big Data, la nuova materia prima del Business 4.0

I Big Data trasformano Business Intelligence e Analytics

Artificial Intelligence, al di là della Robotic Process Automation